CHiME(Computational Hearing in Multisource Environments)大赛组委会于当地时间9月6日宣布:国家智能语音创新中心、科大讯飞与中科大语音及语言信息处理国家工程研究中心(NERCSLIP)联合团队,在参与的全新Task 2——“会议室场景远场多人语音识别”(NOTSOFAR)任务中再获佳绩,获得全部两个赛道的第一名,这也是创新中心连续2届收获冠军。

作为“最难语音识别任务”之称的语音领域国际权威赛事,CHiME(Computational Hearing in Multisource Environments)从2011年发起,今年已是第八届。此次Task2任务吸引了约翰霍普金斯大学、捷克布尔诺理工大学、奈良先端科学技术大学院大学、西北工业大学、南京大学、腾讯天籁实验室等国内外知名研究机构、高校和企业参与角逐。

难度升级,再掀新挑战浪潮

CHiME每一届的任务设置和难度都在变化和提升,语音识别任务的复杂性和挑战性持续加强。此次比赛的新任务面向会议室场景,难度再升级:会议场景覆盖了30个不同的会议室,每个会议室尺寸、布局、建筑材料和声学特性不同,会议主题也不相同;

识别人数从固定的4人增加到动态的4到8人;

多人同时讲话导致了语音重叠、打断,以及说话人快速切换。其中,测试集语音重叠比例平均达到了39.5%;

需要处理不同的声学场景,比如说话人起身在白板附近说话、边走边说,声音的距离和音量都会有变化;

还要处理不同类型的干扰噪声,比如关门声、电话铃声、空调噪声等。

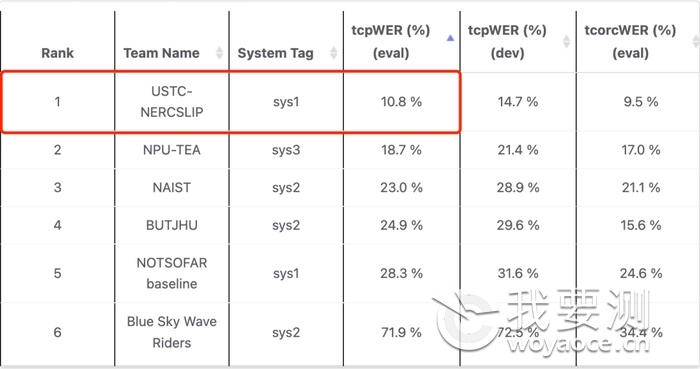

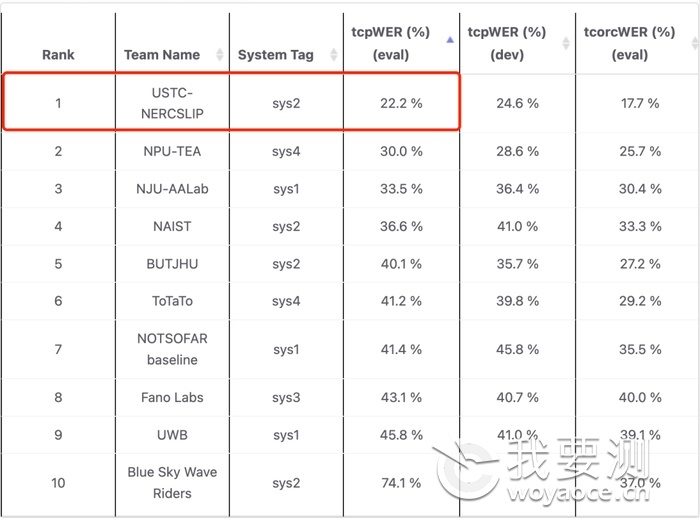

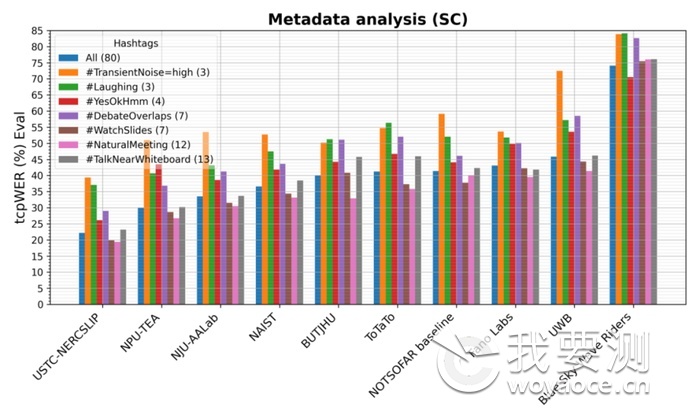

本届CHiME-8的Task2任务设有两个主要赛道:单通道语音识别(SC, Single-channel)和已知麦克风阵型的多通道语音识别(MC, Multi-channel)。联合团队参加了所有两个赛道,在单通道赛道上语音识别错误率(tcpWER)降至22.2%,领先第二名30.0%,相比基线系统降低了46.4%;在多通道赛道上语音识别错误率(tcpWER)降低至10.8%,领先第二名46.4%,相比基线系统降低了61.8%;且在细分的7个声学场景下的表现都优于其他团队,体现了所提交系统在多种噪声、会议特性环境中的鲁棒性。

多通道赛道tcpWER结果和排名

单通道赛道tcpWER结果和排名

单通道赛道7个细分声学场景下的tcpWER结果,值越低成绩越好INNOVATION

应对挑战,实际成效如何?

复杂的会议场景中,如何实现高精准的语音识别和说话人分离?

联合团队针对新场景中的关键问题,基于长期的技术积累与实践反馈,创新并采用了多种技术方法,突破了语音重叠、远场混响、人员移动等难关。基于重叠声检测和语音分离的多说话人迭代聚类角色分离算法(Speaker Clustering Based on Overlap Detection and Speech Separation)

该方案旨在解决高噪声、多说话人高度重叠和说话人时长分布不均场景下说话人角色分离不准、人数漏估等问题。针对多个说话人同时说话、声纹特征提取不准的情况,团队设计了重叠声检测模块,可以利用该模块区分重叠和非重叠片段,并通过语音分离模块将重叠片段中的每个说话人声音独立分离出来。

同时,网络结构更深、短时效果更优的ResNet-221结构用于提取分离语音和非重叠段原始语音的声纹特征,并结合重叠段近邻限制的聚类算法,极大降低了人数估计错误率,有效提升了角色分离的准确度。此外,联合团队还基于第一轮生成的GSS(Guided Source Separation)分离音频进行迭代聚类,进一步修正音色相似或分离音频畸变导致的说话人数错估、角色错分等情况,从而大幅度降低了后续语音识别任务的错误率,为复杂语音场景下的应用提供了更为可靠的技术支持。长短时空间滤波(Long-Short Spatial Filter)

该方案基于麦克风阵列并结合说话人角色分离技术,在空间层面解决会议远场语音识别中存在的背景噪声、语音重叠、音量过低、说话人走动等难点问题。在提出的多说话人迭代聚类角色分离算法基础上,针对会议场景特点,提出长短时空间滤波(Long-Short Spatial Filter)的方案,通过CACGMM(Complex Angular Central Gaussian Mixture Model)在长时语音段上对每个说话人建模,有效避免某个说话人有效语音片段过少导致的估计偏差。

同时,为了避免说话人走动带来的长时信息估计不准确,在短时语音段上,结合长时估计统计量和角色分离提供更加精细的时频点掩蔽信号(Time-Frequency Mask),有效捕捉移动说话人变化的空间信息,得到最终更加鲁棒和精确的说话人时频分布估计。最终波束形成算法在上述时频点掩蔽信号指导下,通过准确滤除背景噪声和其他方向干扰人声,有效解决远场信号语音重叠和音量较低问题,从而提升下游识别任务性能。自适应声学与语言模型方案(Adaptive Acoustic and Language Model Method)

该方案专注于提升复杂会议场景中的语音识别性能,在声学模型方面,根据输入音频的特征信息自动选择最合适的专家网络,以有效捕捉不同说话人的语音特征和应对各种环境噪声。在语言模型方面,结合上下文信息,通过对话历史和场景关键词进行动态调整,实时优化语言模型的生成策略。这使得模型能够理解当前对话的主题和参与者的说话习惯,从而生成更合适的识别结果,有效提升了语音识别在复杂场景中的鲁棒性和准确性。

创新、探索与未来

语音是初心,是优势,更是创新中心肩负的责任。

此次挑战赛中涉及的语音识别相关技术目前已在多场景实现了落地应用。联合团队在拿下冠军、领跑国际竞争对手的同时,创新中心在核心源头技术上也实现了自我突破。从开展以声音为核心的工业AI、智能语音检验检测、中试AI云等方面技术研究,到构建面向行业的多个公共服务平台,再到在制造业多元应用场景落地实践的持续探索,创新中心坚持核心技术创新,已基本建成集技术攻关到产业发展与应用于一体的科技创新体系。

多语种技术创新,助推中国制造高质量出海;AI语音交互创新,让万物互联“开口”即得;工业AI技术创新,提升工业智能化水平……现阶段,创新中心相关技术已在家电、汽车、电力、矿业能源等多个领域成功应用。

未来,创新中心仍将持续聚焦关键核心技术突破与产业应用落地,以技术创新推进制造业智能化转型,为发展新质生产力贡献中心力量。